Desbravando o Llama 3.2: Novos Horizontes em AI

Quando me deparei com o anúncio do Llama 3.2, imediatamente pensei: o que mais pode ser feito com essa nova evolução dos modelos de AI? Em um mundo onde cada segundo conta, ter um assistente de AI que não só entende texto, mas também ‘vê' é um divisor de águas. Vamos mergulhar nessa revolução!

O Que Há de Novo no Llama 3.2?

A Meta fez muito barulho ao lançar o Llama 3.2. Essa atualização é uma grande evolução no mundo da inteligência artificial. Mas, o que exatamente há de novo? Vamos explorar suas especificações, fazer uma comparação com versões anteriores e, claro, entender as capacidades de visão dessa nova versão.

Introdução ao modelo Llama 3.2 e suas especificações

O Llama 3.2 entra na cena com recursos que prometem mudar a maneira como interagimos com a inteligência artificial. Para começar, a nova versão agora suporta capacidades de visão. Isso significa que o modelo pode “ver” e “entender” imagens, aumentando seu potencial além do texto. Essa inovação é um salto significativo para a família Llama.

Comparação com versões anteriores: Llama 3.0 e 3.1

- Llama 3.0: A primeira grande versão da série. Sem muitas capacidades além da compreensão textual.

- Llama 3.1: Trouxe melhorias notáveis, mas ainda estava focada apenas em texto.

- Llama 3.2: Com a adição de capacidades de visão. Aqui, temos uma mudança de jogo.

É interessante ver como as atualizações sempre se acumulam. Você também se sente animado com essas mudanças? A cada passo, a Meta parece estar mais perto de criar uma IA realmente abrangente.

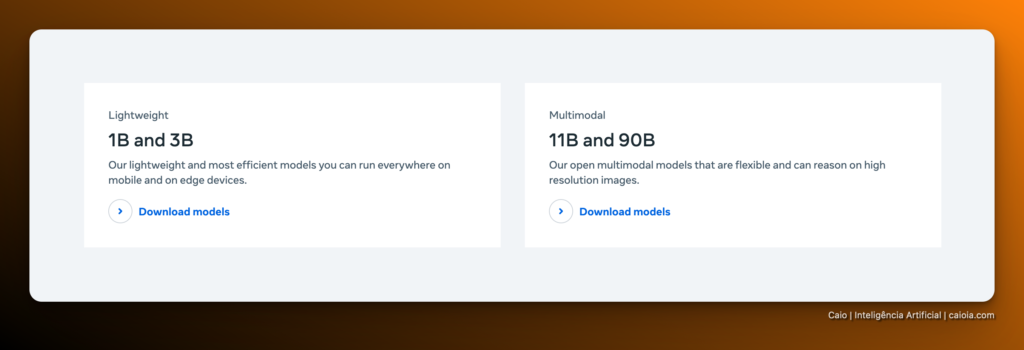

3. Modelos com capacidades de visão: 11 bilhões e 90 bilhões de parâmetros

A nova versão traz modelos com 11 bilhões e 90 bilhões de parâmetros, ambos com essa incrível capacidade visual. Esses modelos não só substituem os irmãos mais velhos em tarefas de compreensão de texto, mas agora também integram compreensão visual. Isso é algo que eu já espero há anos!

| Tamanhos de Modelo | Parâmetros |

|---|---|

| Modelo 1B | 1 bilhão |

| Modelo 3B | 3 bilhões |

| Modelo 11B | 11 bilhões |

| Modelo 90B | 90 bilhões |

Esses novos modelos permitem um leque de aplicações, que vão desde a compreensão de imagens até tarefas complexas de manipulação de texto. Por exemplo, com o 11B e 90B, podemos esperar um desempenho melhorado em tarefas de legendagem e análise de imagem. Além disso, não se esqueça: a Meta está focando em dispositivos edge. Como diz um famoso ditado,

“O futuro da AI está nos dispositivos edge; menos é mais quando se trata de eficiência.”

Por fim, a Meta tem se empenhado em garantir que essa nova geração de modelos seja compatível com versões anteriores. Isso é ótimo para os desenvolvedores, pois não precisam renovar todo o seu código.

A Revolução do Edge AI

Estamos vivendo uma era onde a inteligência artificial está cada vez mais perto de nós. Não, não me refiro apenas a grandes servidores na nuvem. Falo de uma tecnologia que se torna parte integrante dos nossos dispositivos cotidianos. É aqui que entra o Edge AI.

Definição de Edge AI

O Edge AI é uma forma de inteligência artificial que processa dados localmente, em vez de depender da nuvem. Isso significa que dispositivos como smartphones, tablets, e outros gadgets são capazes de realizar tarefas complexas de forma imediata e eficiente. Mas por que isso é tão relevante? A resposta está na velocidade e na privacidade. Imagine dirigir um carro autônomo que precisa de dados em tempo real. Você quer que ele se conecte à internet constantemente? Não! Ele deve processar informações instantaneamente ao seu redor.

Vantagens dos modelos compactos

Modelos compactos de AI são otimizados para desempenho em dispositivos de borda. Eles oferecem as seguintes vantagens:

- Desempenho melhorado: Executam funções rapidamente sem a necessidade de conexão com a nuvem.

- Privacidade: Os dados não precisam sair do dispositivo, reduzindo riscos de vazamento.

- Menor consumo de energia: Dispositivos gastam menos energia ao processar informações localmente.

Casos de uso em dispositivos móveis e IoT

Os casos de uso do Edge AI são vastos e intrigantes. Aqui estão alguns exemplos:

- Reconhecimento facial: Usado em smartphones para desbloqueio imediato e segurança.

- Assistentes pessoais: Como Alexa e Google Assistant, que respondem em questão de milissegundos.

- Dispositivos IoT: Sensores em casas inteligentes que analisam dados ambientais em tempo real.

Dados otimizados para processadores

Modelos de 1B e 3B estão otimizados para rodar em processadores MediaTek e Qualcomm. Veja a tabela abaixo para entender melhor essas otimizações:

| Modelo | Parâmetros | Otimização |

|---|---|---|

| Modelo 1B | 1 bilhão | MediaTek, Qualcomm |

| Modelo 3B | 3 bilhões | MediaTek, Qualcomm |

“AI na borda (Edge AI) é o futuro – tanto em eficiência quanto em privacidade.”

O Edge AI é, sem dúvida, um passo importante para um futuro onde os dispositivos se tornam mais autônomos e seguros. Estamos construindo relações mais próximas com a tecnologia que usamos diariamente, e isso é apenas o começo!

Benchmarking: Como o Llama 3.2 se Compara?

Recentemente, o lançamento do Llama 3.2 trouxe muitas expectativas ao mundo da inteligência artificial. O que faz esse modelo se destacar no mercado? Vamos explorar uma análise comparativa com outros modelos e os resultados de testes de eficiência e velocidade.

Análise Comparativa com Outros Modelos

Quando comparamos o Llama 3.2 com modelos como o Claude III Haiku e o GPT-4o Mini, logo podemos notar que o Llama se destaca em velocidade e eficiência. Você já parou para pensar por que isso acontece? Em um mundo onde cada segundo conta, ter uma IA rápida pode ser a diferença em várias aplicações.

Resultados de Testes

Os benchmarks realizados com o modelo 3B apresentaram resultados surpreendentes. Veja uma tabela simples com os dados:

| Dataset | Resultado |

|---|---|

| MMLU | 63.4 |

| GSM8K | 77.7 |

| Arc Challenge | 78.6 |

Esses números mostram que, mesmo sendo um modelo menor, o Llama 3.2 performa de forma competitiva. E mais: o impacto desses modelos nas aplicações de AI é imenso. Com uma capacidade de execução em dispositivos de borda, é possível rodar esses modelos em celulares e computadores, o que é revolucionário para a IA no dia a dia.

Impacto nas Aplicações de AI

Os resultados dos benchmarks demonstram que mesmo os menores modelos do Llama 3.2 competem com os maiores no mercado. Isso é crucial, pois a eficiência de modelos menores não deve ser subestimada. Esses modelos são projetados para serem rápidos e altamente eficazes, prontos para diversas tarefas como sumarização e reformulação.

“Desempenho em comparação com modelos como Claude III Haiku e GPT-4o Mini: Llama se destaca em velocidade e eficiência.”

Ao considerar a crescente importância da computação em dispositivos de borda, a inovação trazida pelo Llama 3.2 representa um passo significativo na evolução da IA. Estamos apenas começando a ver o potencial real que esses modelos menores podem trazer.

Portanto, ao analisar o cenário competitivo entre os modelos de AI, Llama 3.2 realmente se destaca com suas inovações e eficiência. E quem sabe, no futuro, ele não pode transformar completamente a forma como interagimos com a tecnologia? O que você acha?

Futuro das Aplicações de AI com Llama 3.2

Possibilidades de Aplicações Práticas

O Llama 3.2 traz novas capacidades, incluindo a visão computacional, que pode ser utilizada em diversas áreas. Aqui estão algumas aplicações práticas:

- Assistência Virtual: Implementação de assistentes mais inteligentes nos serviços de atendimento ao cliente.

- Reconhecimento de Imagem: Melhor interpretação de imagens em setores como saúde e segurança.

- Aprimoramento do Marketing: Análise de comportamento do consumidor através de dados visuais.

- Educação: Ferramentas que assistem na aprendizagem de maneira mais interativa.

A Importância do Llama Stack para Desenvolvedores

O Llama Stack é fundamental nesse contexto. Ele oferece um conjunto de ferramentas que facilitam a criação de aplicações de IA. Com a capacidade de trabalhar em dispositivos locais, na nuvem ou em ambientes híbridos, o Llama Stack é um verdadeiro divisor de águas na implementação de AI.

“Para os desenvolvedores, o Llama Stack é um verdadeiro divisor de águas na implementação de AI.”

A conexão entre desenvolvedores e a Meta torna-se essencial para promover a inovação. As ferramentas disponíveis permitem que qualquer desenvolvedor, independentemente do nível, possa integrar a IA em suas aplicações de forma simplificada.

Expectativas de Evolução Futura dos Modelos Llama

Os modelos Llama estão em constante evolução. O Llama 3.2 trouxe melhorias significativas em relação aos seus antecessores. Com a possibilidade de visualização e modelos de tamanhos variados, isso abre um leque de opções para futuras implementações.

| Modelo Llama | Parâmetros | Funcionalidade |

|---|---|---|

| Llama 3.2 | 11 bilhões | Capacidades de visão e linguagem |

| Llama 3.2 | 90 bilhões | Capacidades de visão e linguagem |

| Llama 3.2 | 1 bilhão | Execução em dispositivos de borda |

| Llama 3.2 | 3 bilhões | Execução em dispositivos de borda |

Essas inovações mostram que estamos apenas começando. O futuro da IA não é apenas sobre eficiência; é sobre como podemos aplicá-la em nossas vidas diárias. A revolução da IA está aqui, e todos nós podemos aproveitá-la.

TL;DR

O Llama 3.2 da Meta revolucionou as aplicações de IA com novas capacidades, como a visão. O Llama Stack simplifica o trabalho dos desenvolvedores. Este é apenas o começo da evolução dos modelos Llama, com muitas oportunidades práticas pela frente.